特斯拉美国车型取消毫米波雷达,纯视觉图像系统将成为主流?

最近,有关特斯拉是否会使用雷达作为自动驾驶传感器的两则消息,引起了业内关注。一则消息是特斯拉美国车型Model 3/Model Y取消了毫米波雷达;另一则消息是虽然特斯拉坚持不用激光雷达,但特斯拉却正在路上测试Luminary激光雷达系统。

目前,行业普遍认为,雷达+摄像头的传感器融合是实现自动驾驶的合理路径。作为电动汽车与自动驾驶的践行领先者,特斯拉在未来会不会使用激光雷达,或者继续坚持“特立独行”——不使用雷达、继续只使用视觉传感器(摄像头)来实现自动驾驶?

带着这样的疑问,《车业杂谈》采访了汽车行业资深专家、《车业杂谈》汽车新媒体平台独家特约汽车行业评论员方圆。

01

《车业杂谈》:就最近有关特斯拉对待毫米波雷达、激光雷达的两则消息,您怎么看待?

方圆:我也看到了这两则新闻报道,对于特斯拉,这两件事可谓是里程碑事件。要说清楚这两件事,我想得先从自动驾驶环境感知对传感器/感知系统的要求角度来讨论。

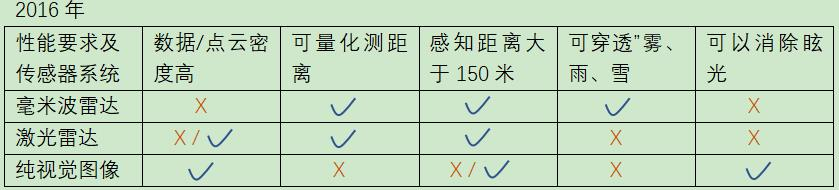

一般来讲,自动驾驶环境感知理想状态的感知系统大致包括以下4个方面:

1.每刻/每幅感知数据/点云/像素足够多或曰其空间分辨率足够高——类似人的眼睛所见的图像以便分析、决策。

2.感知系统提供的数据能给出被感知物体的量化的距离信息(能测量物体距离)。

3.感知系统不受白天或黑夜,不受恶劣天气(雾、雨、雪、眩光等)的影响,是一个全天时、全天候的传感器。

4.感知距离足够远,以便遇到紧急情况,有足够的时间做出判断、决策、执行来避免事故发生,这个距离期望能至少在150米以上。

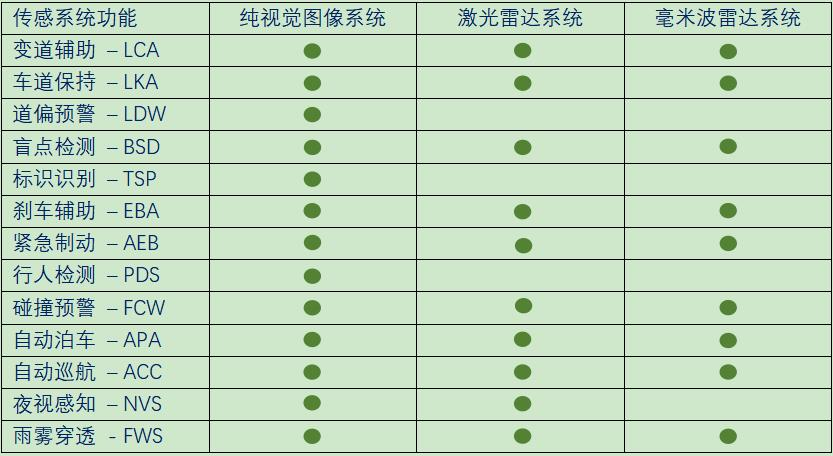

但在以往,并没有任何某一类传感器/感知系统可以同时满足以上全部4项要求。因此,目前几乎所有的自动驾驶环境感知系统都是将几类传感器结合起来走所谓-感知融合/数据融合之路,即将各类传感器/感知系统(如纯视觉图像感知系统,毫米波雷达,激光雷达等)的特长/优势结合起来达到上述目的。

但是,由于技术的进步,目前纯视觉图像感知系统已经可以单独完成上述4项感知任务以及消除眩光等。

对比两表可以看出,纯视觉图像感知系统在很大范围内已经可以替代毫米波雷达以及激光雷达,这应该是特斯拉美国Model 3/Y取消毫米波雷达配置的主要原因。而对比纯视觉图像感知系统,毫米波雷达两个固有短板(画面数据/点云/像素密度低,非金属表面物体反射率低)几乎是没有办法克服,但其优势已经可以被纯视觉图像感知系统替代。

对于特斯拉路试Luminar激光雷达,我认为是在测试其目前的性能指标以及进步情况,如数据/点云/像素的密度进步/增长如何。预计,特斯拉还会继续路试激光雷达,特别是需要详细讨论的Flash式激光雷达,因为Flash式激光雷达也是纯视觉图像感知系统——通过相机视觉图像采集数据(而不是通过扫描)。Flash式激光雷达相机可以并入目前常用的纯视觉图像感知系统相机。

目前,纯视觉图像感知系统的摄像头/相机有一个非常重要的特长/优势,其每刻/每幅感知数据/点云/像素的数据点非常多,空间分辨率非常高,可以看清路标(速度标,警示标等)、路线(实线、虚线、斑马线等)、红绿灯等。同时,由于是RGB(多波长,多颜色)摄像头/相机,其对各种物体表面都有较好反射效果。现在其距离感知也足够远(远超过150米,通常可达300米,最远可达1600米),也能直接测量距离(达厘米级),也能“穿透”雾、雨、雪、眩光等,可以替代毫米波雷达及激光雷达。

02

《车业杂谈》:关于刚才谈到的感知系统的4项性能,您可否就此具体谈谈毫米波雷达、激光雷达,以及纯视觉图像感知系统,哪个最优且满足自动驾驶环境感知系统要求?先谈第一项性能。

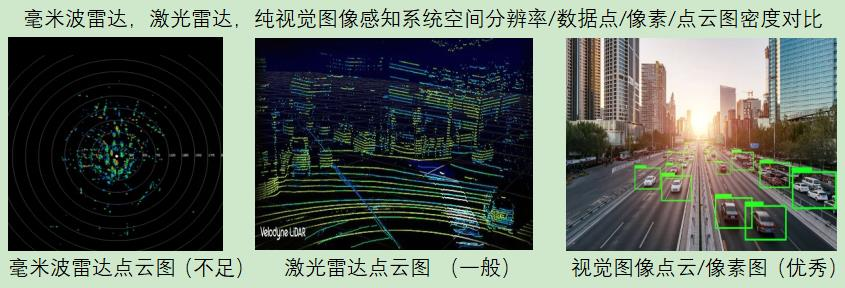

方圆:就第一个性能而言(空间分辨率/数据点/像素/点云图密度),纯视觉图像感知系统最优且满足自动驾驶环境感知系统要求。

这项性能至关重要,它是最接近人类视觉性能的,这应该是为何特斯拉始终坚持认为纯视觉图像系统可以完成自动驾驶环境感知的任务。

其逻辑基础之一是人类也基本上是凭视觉图像来驾驶汽车的;其二是感知系统的实时信息流(bitstream/s – bit/s)是主要、核心、关键指标;其三纯视觉图像系统的性能也在不断扩展,也可以测量距离,也可以实现全天候、全天时的感知任务。从这三点出发,纯视觉图像系统有着常规激光雷达,毫米波雷达不可比拟的优势——纯视觉图像系统的空间分辨率/数据点/像素/点云图密度往往可达激光雷达的100倍左右甚至更高,比毫米波雷达就更高了。可以从下面三者的像素/点云图的对比,明显看出区别。

03

《车业杂谈》:就第二项性能,一般认为毫米波雷达或激光雷达可以给出前方物体的距离信息,而以往的纯视觉图像感知系统往往不能够提供,您怎么看?

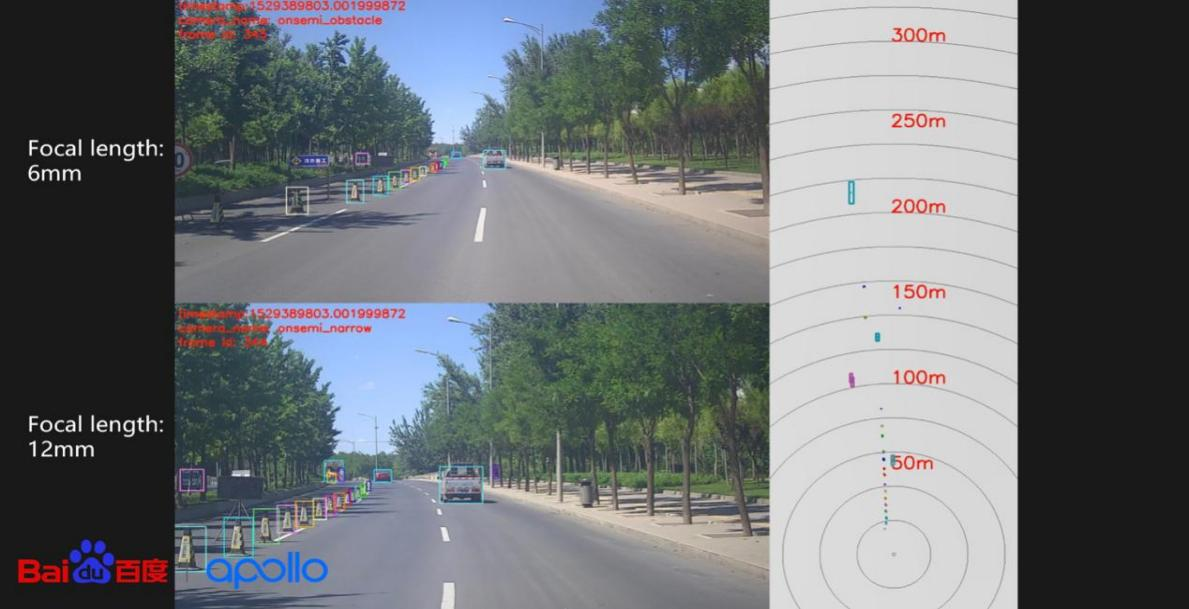

方圆:就第二项性能而言,前方物体及周围的距离信息对于自动驾驶的决策及路径规划非常重要。但目前,除了激光雷达与毫米波雷达可以测量距离外,纯视觉图像感知系统也可以测量距离,如使用单目、双目(类似人类双目/双眼)、三目或多目方法,TOF等方法。

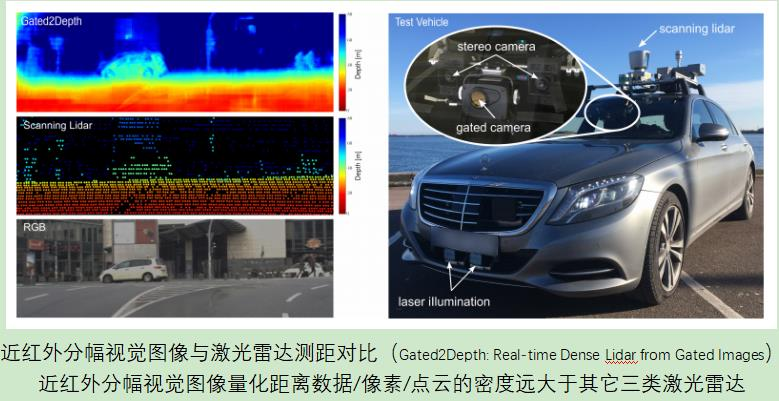

如,2019年IEEE国际计算机视觉大会(ICCV2019)最佳论文提名论文《Gated2Depth: Real-time Dense Lidar from Gated Images-高密度实时快门分幅激光视觉图像测距系统》,2019年IEEE国际计算机视觉与模式识别大会(CVPR2019)百度公开Apollo Lite纯视觉图像感知系统L4级自动驾驶3D感知方案(不依赖激光雷达并具备更高的可量产性),2020年CVPR2020康纳尔大学与香港科大联合发表的论文《Depth Sensing Beyond Lidar Range -超越激光雷达测距的距离测量“视觉”感知系统》,以及2021年清华大学在CVPR 2021发表的文章-《单目实时全身动作捕捉》等论文给出了参考。

以2020年康纳尔大学与香港科大联合发表的文章为例,文章给出在货车上使用三目相机纯视觉图像感知系统进行300米距离测量数据的对比,实际距离302米,测量300.8米,相对误差0.4%。虽然,纯视觉图像距离测量的精准度还没有激光雷达高(厘米个位数),但已经接近毫米波雷达(厘米两位数)。如按照上面例子给出相对误差估算,对于40米左右的刹车距离,测量误差约为16cm。

因此,我认为随着测量技术的进步,纯视觉图像系统的距离测量的精度将会接近并等同于激光雷达。

百度Apollo Lite/ANP(Apollo Navigation Pilot)测距道路实车实测演示图

另外,从单目单个RGB视觉图像也可进行6D姿态估计,能进一步地提升图像信息的利用率,如CVPR 2021发表的文章《GDR-Net:Geometry-Guided Direct Regression Network for Monocular 6D Object Pose Estimation》。

04

《车业杂谈》:就第三个性能而言,一般认为毫米波雷达最大的特点是,除了测距之外还有较强的“穿透力”,对一定的雨、雾、雪可以“穿透”,以往纯视觉图像系统缺乏这个能力,您如何看?

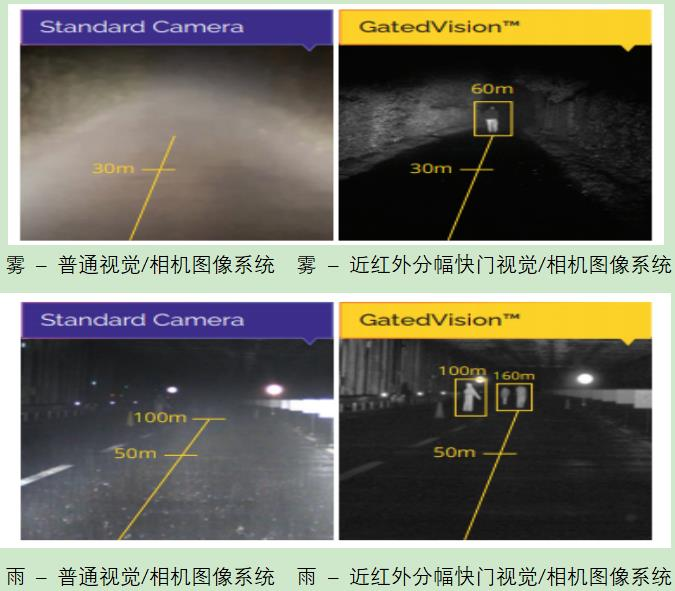

方圆: 的确,由于毫米波雷达的波长较通常可见光的波长要长,为此,其对一定的雨、雾、雪等有较强的“穿透力”。但目前纯视觉图像感知系统已经可以将可见光波长拓延到近红外波段,并配合适当算法,已经可以具有“穿透力”,“穿透”雨、雾、雪等。

如,2018 年IEEE Intelligent Vehicles Symposium (IV)的论文《Benchmarking Image Sensors Under Adverse Weather Conditions for Autonomous Driving-恶劣天气下自动驾驶不同视觉图像传感系统性能对标》给出了参考。

如下图所示,图中对比了普通视觉图/相机像系统与近红外分幅快门视觉/相机图像系统在雾天、雨天条件下获得的视觉图像效果。可以看出,近红外分幅快门视觉/相机图像系统在雨雾雪中也具备很强的“穿透力”(虽然雪的结果没有显示)。为此,纯视觉图像感知系统也具备了类似毫米波雷达的雨、雾、雪等的“穿透”能力(激光雷达不具备)。

05

《车业杂谈》:就第四个性能而言,在常用的自动驾驶环境感知传感器测量距离图中,一般认为纯视觉图像系统的感知距离小于毫米波雷达以及激光雷达,您如何看?

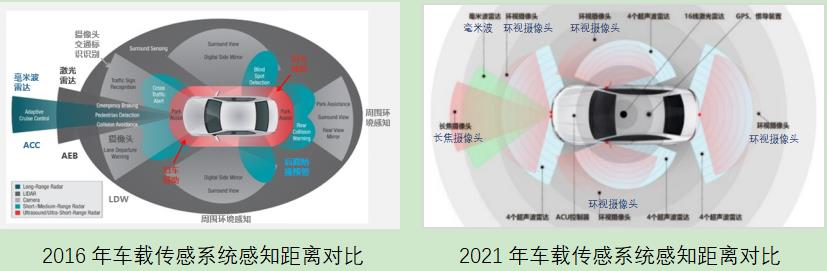

方圆:常用的自动驾驶环境感知传感器距离感知图是几年前的数据,现在也已经有变化了。如下图所示,目前的纯视觉图像系统的感知距离已经达到并超250米,通常可达300米,最远可达1600米(智加科技-2019年6月11日报道),达到并超过毫米波雷达的测距距离,如前面的Apollo Lite,以及港科大文章。目前全球最好的车载毫米波雷达-大陆ARS540有效测量距离为300米。其它大多数一流毫米波雷有效测量距离为250米。另外,通常激光雷达的测量范围在150-250米之间。

06

《车业杂谈》:基于以上4项性能的讨论,您基本说明了为何最近特斯拉美国车型Model 3/Model Y取消了毫米波雷达,因为毫米波雷达的基本性能/功能已经可以被纯视觉图像感知系统的拓展性能/功能所替代;同时,纯视觉图像感知系统也可以测量距离。那么,为何特斯拉又在路试Luminar激光雷达?

方圆:特斯拉路试目前最好的扫描式激光雷达Luminar,我预计其目的之一是将激光雷达所获得的距离信息/数据与其纯视觉图像感知系统所获得的距离信息进行对比。激光雷达一个突出优势是可以精准的测量距离,测量精准度为厘米级。但对于长距离,厘米级的精准度效应增益并不十分显著。另外,纯视觉图像感知系统的距离测量精准度却在不断提高。

07

《车业杂谈》:既然提到了激光雷达,您对不同种类的激光雷达有何看法?

方圆:目前,行业将激光雷达大致分成四类,即机械扫描式、微型机械扫描式/MEMS/共振式、光学扫描式(无运动件),以及固态/Flash式(无扫描式,实时/瞬时获取一幅图)。

行业普遍认为无扫描式、实时/瞬时获取一幅图的固态/Flash雷达更有发展潜力。Flash式有其本身固有的优势,特别是它本身就是视觉图像感知系统,有着与视觉图像感知系统一样的优势——空间及时间分辨率高、空间数据点/点云/像素点密度高、采集每幅/每帧激光图像频率为30Hz(同电视频率)或更高等。其实,它本质上也是前面所提到视觉图像测量距离方法,只是它聚焦在TOF方法上而已。

另据报道,丰田已经确定在L3级自动驾驶车型采用大陆的固态/Flash激光雷达系统(虽然丰田也探索其它形式的激光雷达系统并投资了扫描激光雷达Luminar),长城则采用Ibeo的固态/Flash激光雷达系统。

固态/Flash激光雷达之所以在激光雷达中最有发展潜力,是其本身也是走向了视觉图像系统。换句话来说,其可以归为纯视觉图像系统。当将其它扫描式激光雷达与近红外视觉图像测距系统来比较(如上图所示),则近红外视觉图像测距系统更有发展潜力。奔驰也在测试BWV的近红外分幅/快门视觉图像感知系统(可以看成是“Flash 激光雷达”),包括夜视、穿透、以及测距等如上图所示。左上图近红外分幅/快门纯视觉图像系统距离测量图像(3D),左中图为扫描激光雷达距离测量图像(3D),左下图常规RGB视觉图像2D彩色图,右图为测试车,扫描激光雷达位置图(车顶位置),近红外分幅视觉相机位置图(前挡风玻璃上中部),以及近红外激光发射器位置(前保险杠下中部)。

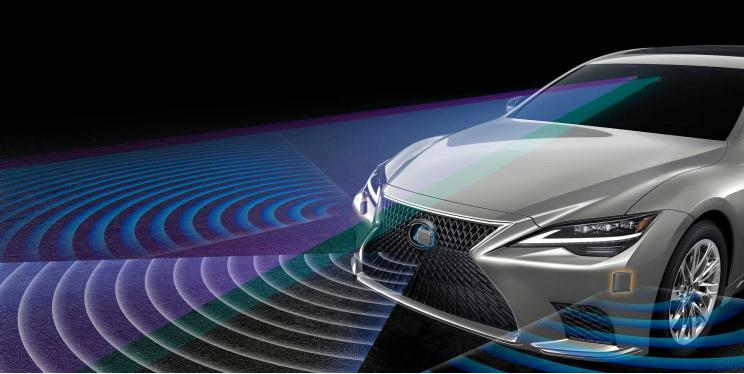

另外,如上面所述,丰田雷克萨斯(如下图)已经搭载/量产了大陆固态/Flash激光雷达(HFL-110),感知/测量距离为50米。

08

《车业杂谈》:自动驾驶环境感知中的另两个挑战是夜间行驶或恶劣天气/夜晚对面相向来车的眩光,那您认为纯视觉图像系统能如何应对?

方圆:首先为了解决恶劣天气/夜晚对面相向来车的眩光(包括开启远光灯)的问题,很多高端/豪华车型研发了智能可控前大灯,遇到相向来车时主动调低灯光以及将灯光偏向以避开相向/对面来车的驾驶员的视角来消除眩光影响。

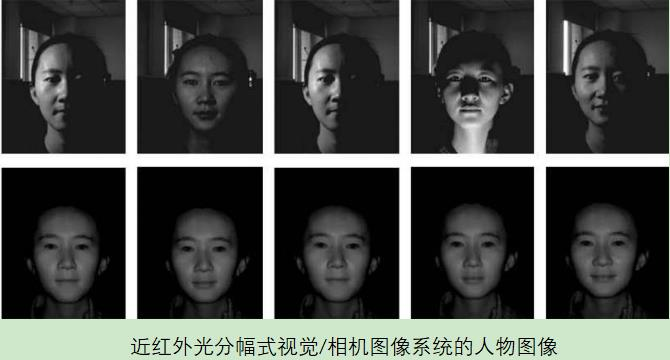

但目前这只能解决自己不产生眩光,无法解决相向来车对自己的眩光的影响。前面提到的最新近红外分幅快门视觉/相机图像系统可以解决这个问题,如下两图所示。左面图中显示了通常视觉图像系统获得的眩光,右面图中显示了红外分幅快门视觉/相机图像系统所获得的图像,没有了眩光效应。

其次,夜间行驶是自动驾驶重要的应用场景,特别是对特种车辆/车型L4级自动驾驶而言。近红外分幅快门视觉/相机图像系统可以协助车辆通常的照明系统来解决这个问题,如下图所示。注:通常大灯GB7258--1997《机动车运行安全技术条件》,近光灯10-30米,远光灯80-120米。卤素大灯100米以下,氙气大灯可达150米,LED大灯可达300米,激光大灯可达600米。氙气、LED、激光,特别是LED及激光大灯的亮度较强,对人眼有些刺激。近红外光则可以避免这些问题。

近红外光分幅式视觉图像系统还可以使白天的视觉图像更加清晰、不受太阳光照射角度的影响,示意图如下图中的人物图像所显示。近红外光分幅式视觉图像系统可以在某一时刻“分幅/切片/聚焦”在某一空间的某一成像的平面上。

09

《车业杂谈》:最后,从硬件及同分辨率/数据点/像素密度的角度来看,您认为纯视觉图像系统中的相机场景数据融合较不同感知系统(毫米波雷达,激光雷达,视觉图像系统)的场景数据融合有何不同?

方圆:纯视觉图像系统中的相机场景数据融合与不同感知系统的场景数据融合有很大的不同。

首先,由于空间及时间分辨率/像素/点云密度不同,导致不同感知系统之间的场景数据融合有很大挑战。如最近阿里达摩院在CVPR2020发表的论文《Structure Aware Single-Stage 3D Object Detection from Point Cloud》,为了同时提升精准度及效率将常用的激光雷达(Lidar)单阶段检测器 (single-stage)与两阶段检测器 (two-stage) 3D 物体检测方法进行优化,将其各自的优势结合起来已达到高精准度及高效率。该方法/检测器曾在 KITTI BEV(bird`s eye view)排行榜上排名第一,如下图所示。

但即使这样,与直接将纯视觉图像系统中的相机场景数据融合进行3D 物体检测相比,还是要多出了一些中间步骤。

直接将纯视觉图像系统中的相机场景数据融合进行3D 物体检测有其它方法不可比拟的优势——对各类视觉图像系统,可以设置一样的空间及时间分辨率。

写在最后:

基于以上对方圆的访谈,我们可以得到如下结论:

1、特斯拉美国车型Model 3/Model Y取消毫米波雷达,是因为毫米波雷达所具有的可测量距离、具“穿透性”优势不再,且相比激光雷达、纯视觉图像感知系统,其劣势分辨率低(目前最好的数据/点云密度还不及8线激光雷达,离纯视觉图像感知系统差距更大)越发明显。同时,在某些非金属物体表面上反射的局限也将成为应用毫米波雷达的主要制约之一。毫米波雷达车载的应用发展趋势将面临巨大挑战。

2、四种激光雷达中,最有发展潜力的是具有高空间及高时间分辨率的视觉图像固态/Flash式激光雷达。因为,Flash式激光雷达实质也是纯视觉图像感知系统,是每次获取整幅图像,可以归类为纯视觉图像感知系统。扫描式激光雷达由于扫描时间大致会产生近百毫秒左右的延迟,在高速公路行驶时将影响决策速度。在同样的线数下,提升扫描速度则会降低空间分辨率,两者不可兼得。而Flash式激光雷达获取图像的速度可至微秒级、甚至纳秒级。

3、目前特斯拉坚持使用纯视觉图像感知系统,是因为纯视觉图像感知系统具备独特优势。

它除了具有高空间及高时间分辨率外,也可以用单目、双目、及多目,以及TOF等方式测量距离,成为视觉雷达(Ranging)。测量及感知距离最远也可达1600米(一英里)。同时,还可以将其波长拓延到近红外波段以穿透雾、雨、雪,消除黑暗及眩光。另外,还可以进一步地拓延到远红外或得物体热度信息。注:经过奔驰/欧洲DENSE自动驾驶研究项目的独立测试,近红外分幅式(Gated)纯视觉图像系统GatedVision 是仅仅唯一一个能够感知/检测/看见恶劣天气条件下(雾、雨、雪、黑暗、眩光)所有被测试目标。引网上报道:“目前除了特斯拉之外,Mobileye、百度、大疆车载也都在做纯视觉方案的研究,通过视觉算法模拟出环境深度信息。华为在极狐 阿尔法 S HI 版上也搭载了双目摄像头,原理同样是通过视觉比对获得深度信息。”

综上所述,全波段全天候全天时3D纯视觉图像感知检测系统(远距离,高时空分辨率,恶劣环境/天气穿透力,夜视等)是自动驾驶环境感知的发展趋势,将成为主流配置。预计其将于2025年在L4/L5级自动驾驶车辆,特别是在L4级自动驾驶商用车、货车、特种车型上规模化量产。

注:文中部分图片来自网络

-

凤凰网汽车公众号

搜索:autoifeng

-

官方微博

@ 凤凰网汽车

-

报价小程序

搜索:风车价

.png)

.png)